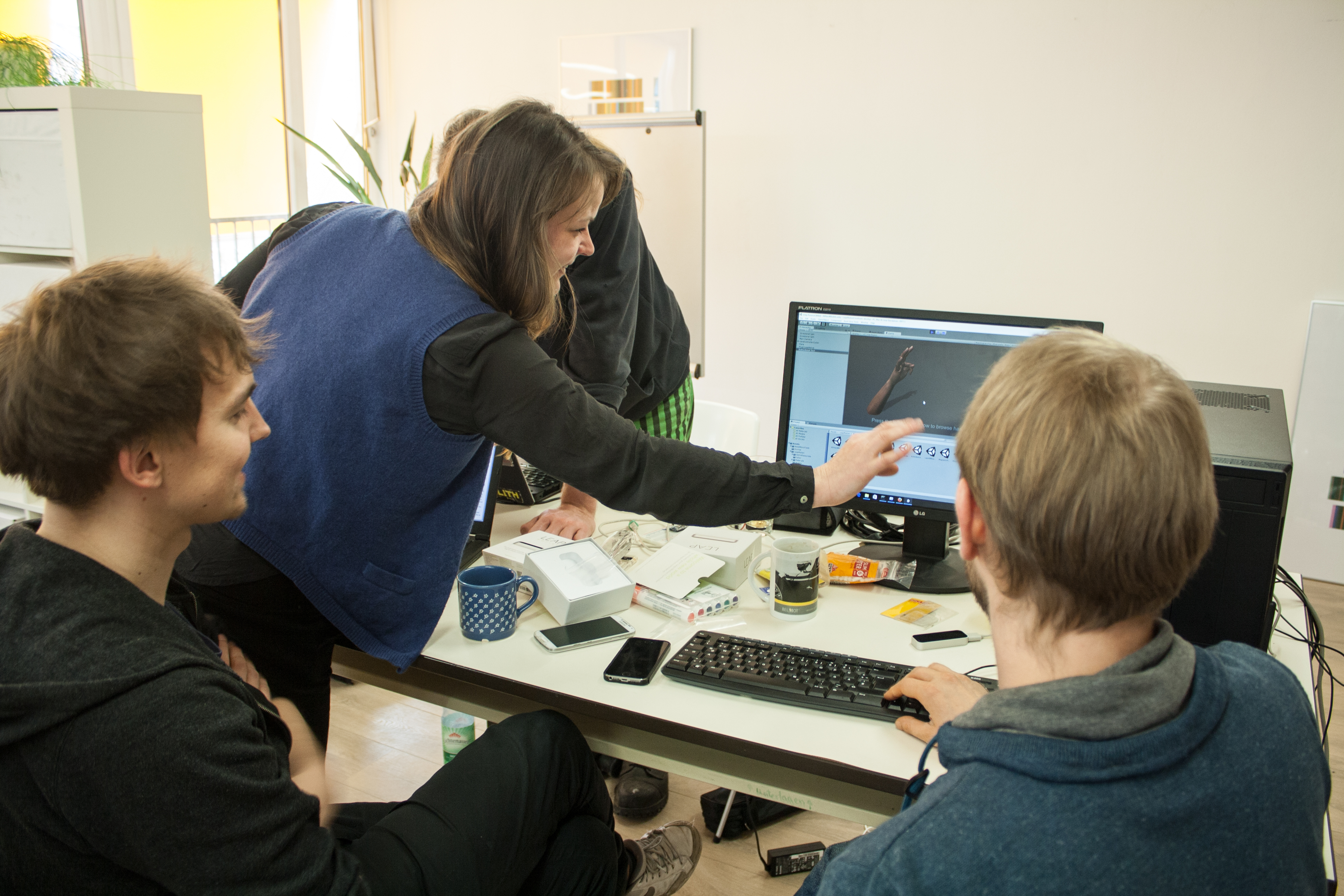

(auf dem Bild sieht man Katas Irritation als sich das Modell eines sehr haarigen, mänlichen Arms synchron zu den Bewegungen ihres Armes bewegt 🙂 )

Hallo Welt,

wie die Zeit fliegt. Ein ganzer Monat und entgegen der Friedhofsruhe auf unserem Blog, bewegte sich hinter den Kulissen mehr denn je.

Praxis-Phase, Praxis-Phase 🙂

Bis es im Sommer so weit ist und wir COSMOTIC das erste Mal in der Öffentlichkeit präsentieren werden, treffen wir uns ein- bis zwei Mal wöchentlich um uns in einem Arbeitsraum verschanzt der konzentrierten Arbeit hinzugeben. Dabei ist die Idee COSMOTIC ersteinmal als einen Prototyp, eine Beta wenn ihr so wollt, zu entwickeln. Konkret bedeutet das Kozentration auf ein Level, den Kosmos (naheliegend 😉 damit wir die Elemente wie Sensorik, Navigation, Gestik, Spielmechanik, in den Vordergrund rücken können und dies in einer Qualität um evtl. Frustrationen des Interagierenden soweit es eben geht, vorzubeugen. Am letzten Wochenende (zum Zeitpunkt der Verfassens) trafen wir uns um die Teilarbeiten des Leveldesigns, vornehmlich ein schwarzer Raum mit Sternentexturen und einfacher Planetenmodelle, mit den ersten Interfaces zur Orientierung und Navigation zu verbinden. Dabei hat sich Micha in Vorbereitung auf das Treffen dem Thema Teleport gewidmet. Der Teleport ist eine Art Springen im Raum, die es dem Spieler ermöglicht virtuell Distanzen zu überwinden. Dabei lässt der Interagierende den Cursor auf einen Punkt im Level gleiten, aktiviert den Teleportmodus mit einer Geste, um dann mit einer Zweiten den Sprung zu bestätigen. Es erscheint erst einmal ungewöhnlich die Bewegung im Raum in hunderte von Sprüngen zu unterteilen, umgeht aber nicht nur die Einschränkungen des physischen Raumes, sondern mildert das häufig einsetzende Gefühl der Übelkeit bei fließenden Bewegungen in der VR. Diese Gesten werden bei uns durch die stereoskopischen Kameras des Leap-Controllers erkannt. Womit wir auch bei der zweiten experimentellen Frage des Treffens wären. Welche Gesten gibt es? Welche funktionieren? Und wenn ja, wie gut? Dabei sind wir allerdings noch ganz am Anfang. Wir versuchen besonders die Ergonomie und Komplexität zu optimieren, um die häufigen Wechselwirkungen von Spiel und Spieler (Interaktivität) zu fördern. Markus hat sich mit der Integration der Arduino erfassten Sensordaten beschäftigt. Diese werden in Zukunft via OSC in Unity übertragen und bis auf minimale Performanceprobleme, ist damit sein Teilprojekt schon am weitesten fortgeschritten. Wir können also ab sofort Blutsauerstoff, CO2-Werte etc. als dynamische Werte für die Gestaltung mitverwenden.

Weiter gehts!